MADRID, 13 de Diciembre de 2024 (Portaltic/EP) .- Meta ha presentado un nuevo modelo diseñado para resolver problemas centrados en el movimiento humano y una herramienta que inserta una marca de agua en los vídeos generados por inteligencia artificial para ayudar a identificar su origen.

Motivo, Video Seal y CLIP 1.2 son solo tres de las novedades en inteligencia artificial generativa que Meta FAIR ha presentado el jueves, con los que busca destacar sus "innovaciones recientes en el desarrollo de agentes, robustez y seguridad, y arquitecturas que facilitan el aprendizaje automático".

Motivo es un modelo fundamental desarrollador para controlar el comportamiento de agentes virtuales encarnados, esto es, exhibir una amplia variedad de comportamientos más parecidos a los humanos.

Para ello, el equipo de Meta FAIR ha recurrido a un conjunto de datos de movimientos sin etiquetar y al aprendizaje de refuerzo no supervisado para entrenar un algoritmo y hacer que aprenda "comportamientos similares a los humanos"

"La novedad técnica clave de nuestro algoritmo es aprender una representación que se puede utilizar para incorporar estados, movimientos y recompensas en el mismo espacio latente", explican en el blog de Meta. El modelo, además, adapta su movimiento a los cambios del entorno, , como la gravedad, el viento o perturbaciones directas, "a pesar de no haber sido entrenado para ellos".

Los investigadores confían en que este avance puede ayudar a crear personajes no jugables (NPC, por sus siglas en inglés) "más realistas" y a democratizar tanto la animación de personajes como la creación de nuevas experiencias inmersivas.

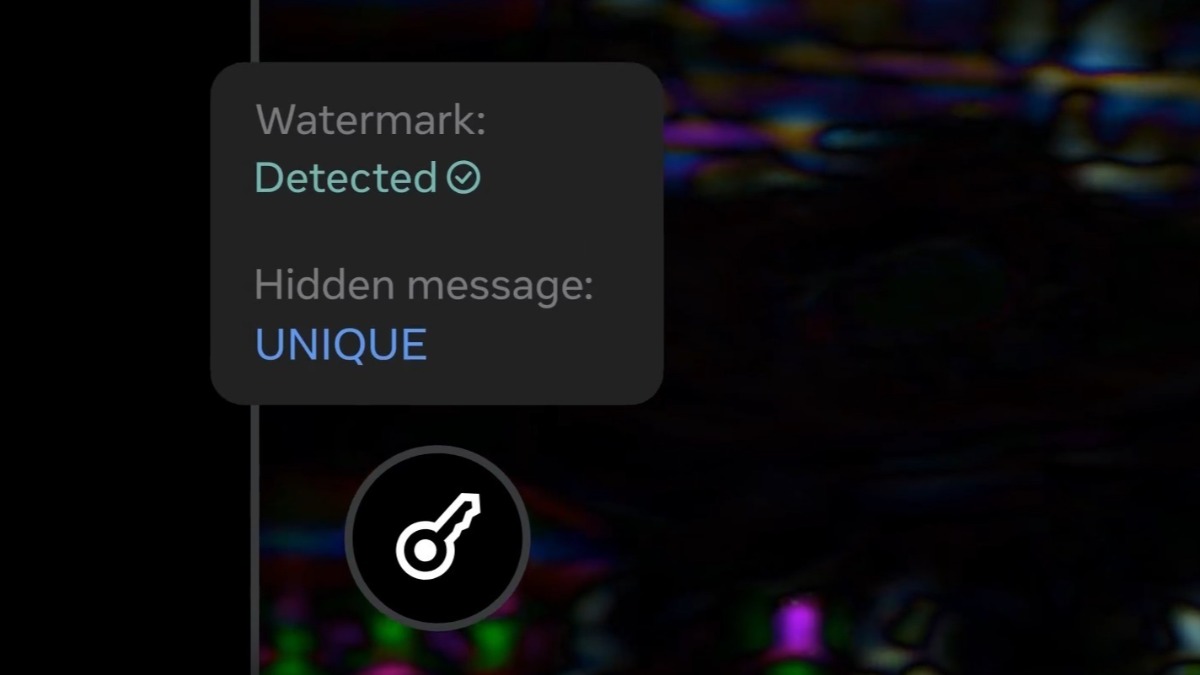

Meta FAIR ha lanzado Video Seal, una marca de agua que se añade a un vídeo generador por IA, imperceptible a simple vista. Se añade "como un mensaje oculto", que permite trazar el origen del vídeo, y que resiste a la edición y a los algoritmos de comprensión que se usan para subir contenido 'online'.

Junto a esta herramienta, la compañía tecnológica también ha lanzado Meta Omni Seal Bench, una tabla de clasificación que compara el rendimiento de distintos métodos de marca de agua. Y ha anunciado la disponibilidad de CLIP 1.2, un modelo básico de codificación de visión y lenguaje de alto rendimiento.

A ello se suman los trabajos en el paradigma generativo Flow Matching, que reemplaza la difusión clásica y mejora el rendimiento y la eficiencia al tiempo que permite una generalización fácil a datos complejos.

En lo que respecta a los agentes, Meta FAIR ha presentado Explore Theory-of-Mind (Explorar la teoría de la mente), una generación de datos adversarios guiada por programas para el razonamiento de la teoría de la mente que permite la generación de datos diversos, desafiantes y escalables tanto para el entrenamiento como para la evaluación de los modelos de lenguaje de gran tamaño.

Otra novedad es el modelo de concepto grande, que se inspira en la inspirado en la forma en que los humanos pueden planificar pensamientos de alto nivel para comunicarse. Asimismo, ha avanzado los trabajos en el transformador latente de bytes metadinámicos y en capas de metamemoria.

Articulo sin comentarios